Crear un centro de cálculo y procesamiento de datos con agrupaciones de ordenadores de segunda mano, además de los proyectos expuestos en el artículo siguiente, puede permitir, con los modelos disponibles en la actualidad, iniciativas que podrían gestionar, por ejemplo, unas cada vez más extensas redes monetarias nominativas locales o regionales, ya sean a nivel de municipios, comarcas o incluso de comunidades geopolíticas soberanas.

Crear un centro de cálculo y procesamiento de datos con agrupaciones de ordenadores de segunda mano, además de los proyectos expuestos en el artículo siguiente, puede permitir, con los modelos disponibles en la actualidad, iniciativas que podrían gestionar, por ejemplo, unas cada vez más extensas redes monetarias nominativas locales o regionales, ya sean a nivel de municipios, comarcas o incluso de comunidades geopolíticas soberanas.

Con el recurso de un edificio con un espacio lo suficientemente grande, el sistema podría ser aplicado con una economía en su inversión compatible con unos tiempos como los actuales, caracterizados por la austeridad en los recursos. Aún así, puede ofrecer una capacidad de procesamiento suficiente para no colapsar el sistema, soportando un número cada vez más elevado de transacciones y de agentes de mercado.

Este artículo ya fue dado a conocer dentro del sitio web del Centro de Estudios Joan Bardina en 2001. A pesar del tiempo transcurrido y la obsolescencia de los recursos empleados en aquel tiempo por sus autores, recuperar este documento del olvido puede permitir, a quienes lo leemos, que podamos aplicar la idea de que ofrece, debidamente actualizada, en nuevos proyectos que se quieran poner en marcha.

Equipo del Centro de Estudios Joan Bardina.

Jueves, 13 de abril del 2017.

El superordenador Beowulf.

Investigación y ciencia. Octubre de 2001.

William

W. Hargrove, Forrest M. Hoffman y Thomas Sterling.

Se ha encontrado un procedimiento económico para resolver problemas computacionales de extrema dificultad: la interconexión de ordenadores personales para que trabajen coordinados.

En el famoso cuento de la sopa de piedras, un soldado perdido se detiene

en un villorrio, donde alardea de su capacidad para hacer una sopa con

sólo agua y un canto pulido. Los habitantes del pueblo, inicialmente

escépticos, acaban, compasivos, trayendo pequeñas aportaciones:

el corazón de un repollo, un manojo de zanahorias, un trozo de carne,

etcétera. Al final, el caldero contiene sopa suficiente para saciar

a todos. La moraleja a extraer es inmediata: con la cooperación

se alcanzan resultados notables, aun cuando se parta de contribuciones

pequeñas, a simple vista insignificantes.

Los investigadores recurren a una estrategia similar de cooperación

para construir superordenadores, las potentes máquinas que realizan

miles de millones de cálculos por segundo. En su mayoría

hacen uso del procesamiento en paralelo; constan de numerosos microprocesadores

de alta velocidad que trabajan en tándem para resolver problemas

de la complejidad de la previsión del tiempo o la simulación

de explosiones nucleares. Fabricados por IBM, Cray y otras empresas, cuestan

decenas de miles de dólares, un precio prohibitivo para los grupos

de investigación con modesto presupuesto. No les ha quedado otro

remedio a las universidades y laboratorios estatales que aprender a construir

sus propios superordenadores. ¿Cómo? Mediante la interconexión

de ordenadores personales y la elaboración de programas que permiten

que estos computadores de mesa resuelvan problemas enrevesados.

En 1996 dos de los autores (Hargrove y Hoffman) nos hallábamos

en un apuro así. Trabajábamos en el Laboratorio Nacional

de Oak Ridge (ORNL) en Tennessee. Nos proponíamos levantar un mapa

nacional de ecosistemas regionales, definidos por condiciones ambientales:

todas las zonas con el mismo clima, estructura geológica y características

del suelo se engloban en la misma ecorregión. Para levantar un mapa

de alta resolución de los estados contiguos de la Unión,

dividimos el país en 7,8 millones de celdas cuadradas, cada una

con una superficie de un kilómetro cuadrado. Para cada celdilla

había que tomar en cuenta 25 variables, que iban desde la precipitación

mensual media hasta la concentración de nitrógeno en el suelo.

Una tarea imposible de realizar por un solo ordenador personal o estación

de trabajo. Se requería un superordenador de procesado en paralelo,

que, además, estuviera a nuestro alcance.

Optamos por formar una agrupación o batería de ordenadores

anticuados, de los que el ORNL se hubiera desprendido en cualquier caso.

Lo apodamos «superordenador de piedra», pues lo construimos

sin apenas gastar un centavo. Ello no obstaba para que nuestra agrupación

de ordenadores personales (en adelante PC) encerrara potencia suficiente

para cartografiar las ecorregiones con una precisión sin precedentes.

Otros grupos de investigadores han generado luego agrupaciones más

potentes que rivalizan con el comportamiento de los mejores superordenadores

a sólo una fracción del coste de éstos. Tan ventajosa

relación prestaciones-precio ha llamado la atención de algunas

compañías, que piensan ya servirse de agrupaciones para tareas

de cierto nivel de complejidad, por ejemplo la decodificación del

genoma humano. No nos cabe la menor duda de que la implantación

de agrupaciones de ordenadores provocará una revolución en

el campo de los ordenadores, al proporcionar un enorme poder de procesamiento

a cualquier equipo de investigación, universidad o negocio que lo

desee.

Beowulf y Grendel.

La idea de la interconexión de ordenadores no constituía,

en sí misma, ninguna novedad. En los años cincuenta y sesenta,

el ejército norteamericano del aire tendió la SAGE, una red

de ordenadores de válvulas de vacío para protegerse de un

inesperado ataque nuclear soviético. A mediados de los ochenta,

Digital Equipment Corporation acuñó el término «cluster»

(agrupación) al integrar sus minicomputadoras de gama media VAX

para formar un sistema mayor. Las redes de estaciones de trabajo -por lo

general menos potentes que las minicomputadoras, aunque más rápidas

que los PC- se convirtieron en algo común en los centros de investigación.

A principios de los noventa, los científicos empezaron a plantearse

la creación de agrupaciones de PC, inducidos en parte por el bajo

coste asociado a la producción en masa de sus microprocesadores.

Pero lo que reforzó el atractivo de esa idea fue la caída

del precio de Ethernet, la técnica dominante en la interconexión

de ordenadores en redes de área local.

Los avances en la programación facilitaron también el

advenimiento de las agrupaciones de varios PC. En los años ochenta,

Unix se erigió en el sistema operativo dominante para la computación

científica y técnica. Por desgracia, los sistemas operativos

instalados en los PC carecían de la potencia y de la flexibilidad

de Unix. Pero en 1991 un universitario finlandés, Linus Torvalds,

creó el Linux, un sistema operativo similar a Unix y que funcionaba

en los PC. Torvalds permitió que su sistema operativo fuera accesible

de manera gratuita en Internet; en muy poco tiempo, cientos de programadores

comenzaron a aportar mejoras. El sistema operativo Linux, que goza hoy

de gran difusión entre los ordenadores independientes, resulta muy

adecuado para agrupaciones de PC.

La primera agrupación de PC nació en 1994 en el Centro

Goddard de Vuelos Espaciales. La NASA, a la que pertenece dicha entidad,

andaba buscando una solución para los complicados problemas computacionales

asociados a las ciencias de la Tierra y del espacio. Necesitaba una máquina

capaz de alcanzar un gigaflop, es decir, realizar mil millones de operaciones

de coma flotante por segundo. (Una operación de coma flotante es

equivalente a un cálculo simple como la suma o la multiplicación.)

En aquel entonces, un superordenador comercial capaz de alcanzar esta velocidad

venía a costar un millón de dólares, y dedicarlo a

un solo grupo de investigadores resultaba derrochador.

El tercero de los autores (Sterling) decidió adentrarse en el

sistema de agrupaciones de PC, un planteamiento reputado radical en aquel

entonces. Con Donald J. Becker, compañero suyo en el Goddard, Sterling

conectó 16 PC, cada uno de los cuales contenía un microprocesador

Intel 486; emplearon el sistema Linux y una red Ethernet estándar.

Para aplicaciones científicas, esta agrupación de PC alcanzaba

los 70 megaflop, o sea, 70 millones de operaciones de coma flotante por

segundo. Aunque nos parezca poco de acuerdo con los estándares actuales,

esa velocidad no era mucho menor que la de algunos superordenadores comerciales

de aquel momento. La agrupación se construyó, además,

con 40.000 dólares, la décima parte del precio de una máquina

comercial con características similares en 1994.

Los investigadores de la NASA lo denominaron «Beowulf»,

en referencia al joven héroe de la leyenda altomedieval que derrotó

al gigante Grendel arrancándole uno de sus brazos. Con ese nombre

se designa ahora toda agrupación económica e integrada por

PC comerciales. En 1996 aparecieron dos descendientes de la primera agrupación

Beowulf: Hyglac (construido por investigadores del Instituto de Tecnología

de California y del Laboratorio de Propulsión a Chorro) y Loki (montado

en el Laboratorio Nacional de Los Álamos). Cada agrupación

constaba de 16 microprocesadores Intel Pentium Pro. Con un coste inferior

a 50.000 dólares, alcanzaron un rendimiento sostenido de más

de un gigaflop; cubrióse así el objetivo de la NASA.

El sistema Beowulf se nos ofrecía como la solución perfecta

para el problema que nos ocupaba, el mapa ecológico regional de

los Estados Unidos. Con una sola estación de trabajo apenas podríamos

manejar los datos de unos pocos estados; además, no cabía

el recurso de asignar diferentes regiones a estaciones de trabajo distintas,

toda vez que debían compararse y procesarse simultáneamente

los datos ambientales de cada sección del país. En otras

palabras, necesitábamos un sistema de procesamiento en paralelo.

En 1996 formalizamos una solicitud de 64 nuevos PC con microprocesadores

Intel Pentium II para construir un superordenador Beowulf. Pero al tribunal

evaluador de nuestra propuesta en el ORNL le pareció implausible

y la rechazó.

No nos rendimos. Presentamos un proyecto alternativo. Sabíamos

que los PC arrinconados que el Departamento de Energía tenía

en Oak Ridge se sustituían con modelos modernos. En una página

web interna se anunciaban los PC antiguos y se subastaban como material

sobrante. Tras un rápido escarceo descubrimos la existencia de centenares

de ordenadores anticuados, esperando la salida mencionada. Quizá

podríamos construir así nuestra agrupación Beowulf

con máquinas que, concedidas sin coste alguno, reciclaríamos.

Habilitamos una sala del ORNL donde antaño había instalado

un ordenador, y nos dedicamos a recoger los PC sobrantes para montar nuestro

«superordenador de piedra».

La tienda de la ganga digital.

La computación en paralelo se guía por el principio del

«divide y vencerás». Un sistema de procesado en paralelo

secciona un problema complejo en múltiples tareas de componentes

menores. Estas tareas se asignan a los diferentes nodos del sistema -por

ejemplo, los PC que componen una agrupación Beowulf-, que realizan

su cometido de manera simultánea. De la naturaleza del problema

dependerá el rendimiento del procesamiento en paralelo. Un factor

a tener en cuenta es con qué frecuencia deben los nodos comunicarse

entre sí para coordinar su trabajo y compartir resultados parciales.

Hay problemas que requieren dividirse en un número ingente de tareas

minúsculas; puesto que tales problemas desmenuzados necesitan un

intercambio frecuente de información, no son adecuados para procesado

paralelo. Pero los problemas menos sutiles sí pueden repartirse

en porciones mayores. Además, al no demandar tanta interconexión

entre nodos, admiten presta solución con sistemas de procesamiento

en paralelo.

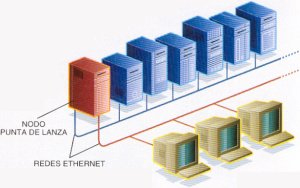

A la hora de formar una agrupación Beowulf se han de decidir

varios aspectos de diseño del sistema. Para conectar los PC podemos

emplear redes Ethernet estándar u optar por soluciones especializadas,

Myrinet por ejemplo. Por motivos presupuestarios escogimos la solución

Ethernet, que es gratuita. Seleccionamos un PC que valiera de punto de

acceso del agrupamiento; instalamos en él dos tarjetas Ethernet,

una para la comunicación con usuarios externos y la otra para la

comunicación con el resto de los nodos, que quedarían conectados

en su propia red privada. A través del intercambio de mensajes entre

los distintos PC se coordinan las tareas, Las dos bibliotecas más

utilizadas para el intercambio de paquetes son la interfaz de mensajería

(MPI, de «message-passing interface») y la máquina virtual

paralela (PVM, de «parallel virtual machine»), ambas disponibles

de manera gratuita en Internet. En nuestro superordenador de piedra operan

ambos sistemas.

Muchas agrupaciones Beowulf son homogéneas: todos los PC tienen

los mismos componentes y microprocesadores. Esta uniformidad simplifica

la gestión y el manejo de la agrupación, pero no se trata

de un requisito imprescindible. Nuestro superordenador de piedra contaría

con una mezcolanza de tipos y velocidades de procesador, pues queríamos

aprovechar cualquier equipo que se nos concediera. Empezamos con modelos

PC que contenían procesadores Intel 486, aunque luego sólo

se incorporaron equipos basados en Pentium con al menos 32 megabytes de

RAM y 200 megabytes de capacidad de almacenamiento en disco duro.

De entrada, no abundaban los ejemplares que estuvieran a la altura de

nuestros objetivos. Hubo que combinar los mejores componentes de diferentes

PC y convertir a éstos en nodos de nuestro sistema. Cada vez que

abríamos una máquina sentíamos la curiosidad del que

desenvuelve un regalo de cumpleaños. ¿Tendría un buen

disco duro, gran cantidad de memoria o una placa madre ampliada (el mejor

de los casos), y se nos había donado por equivocación?. En

numerosas ocasiones sólo encontrábamos un trasto exhausto

con el ventilador cubierto de polvo.

Una vez desatornillado el espécimen, anotábamos sus componentes

en una etiqueta para facilitar luego la extracción de las piezas

de interés. Establecimos una selección de marcas, modelos

y cubiertas preferidas y nos convertimos en expertos descerrajeros de las

claves configuradas por sus antiguos dueños. En promedio había

que desventrar cinco PC para construir un buen nodo.

A medida que cada nuevo nodo se incorporaba a la agrupación,

le cargábamos el sistema operativo Linux. Dimos pronto con la forma

de montar el ordenador sin necesidad de incorporarle monitor y teclado.

Construimos un ingenio capaz de determinar el problema de un nodo deficiente.

Nuestro superordenador de piedra ejecutó su primer código

en 1997. En mayo de 2001 constaba ya de 133 nodos: 75 PC con microprocesadores

Intel, 53 máquinas más rápidas, basadas en Intel-Pentium,

y cinco estaciones de trabajo Alpha de Compaq, más céleres

aún que las anteriores.

No entraña especial dificultad el ir actualizando nuestro superordenador.

Se empieza por reemplazar los nodos más lentos. Dentro de las tareas

de gestión de la agrupación, cada nodo se somete a una prueba

sencilla de velocidad cada hora. La jerarquización de los nodos

en razón de su velocidad nos ayuda a tener un control estricto de

la agrupación. A diferencia de las máquinas comerciales,

el funcionamiento del superordenador de piedra siempre va a mejor, gracias

a la aportación incesante de actualizaciones gratuitas.

Resolución de problemas en paralelo.

La programación en paralelo requiere habilidad e ingenio. Puede

constituir un reto mayor que la propia conjunción de ordenadores

para crear el sistema Beowulf. Por modelo de programación acostumbra

recurrirse a aplicaciones del tipo cliente-servidor. En él, un nodo,

que actúa como cliente, dirige el procesado desarrollado por otro

o varios más nodos servidores. Nosotros ejecutamos el mismo software

en todos los nodos que integran el superordenador de piedra; asignamos

secciones diferentes de código a los nodos cliente y servidor. Cada

microprocesador de la agrupación ejecuta sólo la sección

apropiada para su tarea. Los errores de programación pueden tener

consecuencias importantes y provocar un descarrilamiento general en cadena

cuando del fallo de un nodo se sigue el de los demás. La búsqueda

del error entre los restos del desastre puede resultar muy complicada.

Otro aspecto espinoso es el de la distribución del trabajo para

su procesamiento en paralelo por los PC del sistema. Dado que el superordenador

de piedra alberga microprocesadores dispares, con velocidades muy distintas,

no podemos repartir de una forma homogénea la carga de trabajo entre

los nodos: si actuáramos así, las máquinas más

rápidas estarían ociosas durante largos períodos de

tiempo a la espera de que las más lentas acabaran su procesamiento.

Por eso desarrollamos un programa en cuya virtud el nodo cliente envía

más información a los nodos servidores céleres conforme

van terminando su tarea. En esta organización de distribución

de carga, los PC más rápidos realizan la mayor parte del

trabajo, aunque las máquinas lentas contribuyen al funcionamiento

del sistema.

En la resolución del problema de identificación de las

ecorregiones comenzamos por abordar la organización de la ingente

cantidad de información a manejar: los 25 datos ambientales de cada

una de las 7,8 millones de celdas de los estados contiguos de la Unión.

Generamos un espacio de datos de 25 dimensiones, donde cada dimensión

representaba una variable distinta (temperatura media, índice de

precipitación, característica del suelo, etcétera).

Asociamos a continuación cada celda con el punto correspondiente

del espacio de datos. Por definición, dos puntos próximos

entre sí en el espacio de datos presentan características

similares y, por tanto, se adscriben a la misma ecorregión. La proximidad

geográfica no constituye ningún factor en esa clasificación;

por ejemplo, si dos picos de montaña muestran entornos parecidos,

sus puntos del espacio de datos se hallarán muy juntos entre sí,

con independencia de que les separen físicamente miles de kilómetros.

Con la información organizada, había que especificar el

número de ecorregiones que se mostrarían en el mapa. La agrupación

de PC asigna, a cada ecorregión, una posición seminal dentro

del espacio de datos. Para cada uno de los 7,8 millones de puntos informativos,

el sistema determina la posición seminal más próxima

y adscribe el punto en cuestión a la ecorregión pertinente.

Luego, la agrupación identifica el baricentro o núcleo de

cada ecorregión, es decir, la posición media de todos los

puntos adscritos a la región. Ese núcleo sustituye a la posición

seminal en su calidad de punto definidor de la ecorregión. La agrupación

itera entonces el proceso, reasignando los puntos informativos a ecorregiones

en función de su distancia de los núcleos. Al final de cada

iteración se calculan nuevos núcleos para cada ecorregión.

El proceso se repite hasta que se alcanza la situación en que el

número de puntos informativos que cambian su adscripción

ecorregional es inferior a una cifra preestablecida. En ese momento se

da por terminado el proceso de clasificación.

El levantamiento de mapas constituye una tarea propicia para el procesamiento

en paralelo. Por una razón potentísima: los distintos nodos

de la agrupación analizan de un modo independiente subconjuntos

de los 7,8 millones de puntos informativos. Tras cada iteración,

los nodos servidores envían el resultado de sus cálculos

al nodo cliente, quien promedia los números recabados de todos los

subconjuntos para determinar las nuevas posiciones nucleares de cada ecorregión.

El cliente remite entonces esta información a los nodos servidores

para la siguiente tanda de cálculos. El procesado paralelo permite

también seleccionar, para cada ecorregión, las mejores posiciones

seminales al principio del estudio. Elaboramos un algoritmo que posibilitara

que los nodos de nuestro superordenador de piedra determinasen de manera

colectiva los puntos informativos con mayor grado de dispersión;

se tomarían luego éstos por posiciones seminales. Si la agrupación

arranca con unas posiciones seminales bien dispersas, se requerirán

un número menor de iteraciones para cartografiar las ecorregiones.

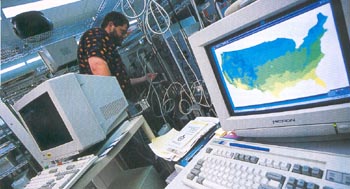

El trabajo empeñado cristalizó en una serie de mapas de

los Estados Unidos que mostraban cada ecorregión en un color diferente.

Los había desde los que representaban al país dividido en

cuatro ecorregiones hasta los que lo partían en 5.000. En los mapas

con un número menor de ecorregiones aparecían zonas fácilmente

reconocibles; los estados de las Montañas Rocosas, por ejemplo,

y el desértico sudoeste. Los mapas con miles de ecorregiones, por

el contrario, ofrecen una complejidad mucho mayor que cualquier clasificación

ambiental del país realizada con anterioridad. Puesto que bastantes

especies vegetales y animales viven en una o dos ecorregiones exclusivamente,

resulta palmario el interés de nuestros mapas para el estudio de

la flora y la fauna en peligro.

En un comienzo, escogíamos al azar los colores de las ecorregiones.

Más tarde buscábamos cierto parecido con el entorno que representaban.

La combinación estocástica de nueve de las variables ambientales

en tres identificadores compuestos nos permitió representarlas

en el mapa con gradaciones de rojo, verde y azul. Cuando se colorea así

el mapa, las tonalidades sustituyen a las líneas de contorno: el

sudeste húmedo verdea, el frío noreste aparece azulado y,

rojo, el oeste árido.

El superordenador de piedra logró incluso representar el desplazamiento

de las ecorregiones en los Estados Unidos en la hipótesis de producirse

variaciones en las condiciones ambientales por culpa del calentamiento

del planeta. Recurrimos a dos situaciones o cuadros climáticos que

habían pergeñado otros grupos de investigación; comparamos

el mapa de ecorregiones actual con los previstos para el año 2099.

A tenor de tales proyecciones, a finales del siglo XXI el entorno ambiental

de Pittsburgh se parecerá al observado ahora en Atlanta; la situación

de Minneapolis, por su parte, se habrá acercado a la de la actual

St. Louis.

El futuro de las agrupaciones.

Para medir el rendimiento de un superordenador se le somete a una serie

de pruebas comparativas, en particular la velocidad de ejecución

de un programa estándar. Eso es lo acostumbrado. Con mayor rigor

científico preferimos centrarnos en su idoneidad para llevar a cabo

aplicaciones estándar. ¿Cómo evaluar nuestro superordenador

de piedra?. Con el fin de averiguarlo, ejecutamos la misma clasificación

de ecorregiones con el superordenador Paragon de Intel, propiedad del ORNL,

poco antes de su jubilación. En su momento fue la máquina

más rápida del laboratorio, con una velocidad punta de 150

gigaflop. Sobre la base del cotejo de procesadores, el tiempo de procesado

del Paragon fue más o menos el mismo que el del superordenador de

piedra. Nuestra agrupación tiene una velocidad máxima de

aproximadamente 1,2 gigaflop. En esta técnica incipiente, más

que la velocidad y capacidad importa dar con un buen algoritmo de procesado

en paralelo.

El sistema Beowulf ha experimentado, desde la construcción del

superordenador de piedra, un desarrollo sorprendente. Se han creado nuevas

agrupaciones con nombres exóticos -Grendel, Naegling, Megalon, Brahma,

Avalon, Medusa y theHive, por sólo mencionar algunos-, que han multiplicado

las prestaciones al alcanzar mayor velocidad a menor coste. En noviembre,

28 de los 500 ordenadores más rápidos del mundo eran agrupaciones

de PC, estaciones de trabajo o servidores. Con sus 512 procesadores Intel

Pentium III, la agrupación de Los Lobos, de la Universidad de Nuevo

México, es el octogésimo ordenador en velocidad; opera a

237 gigaflop. La agrupación Cplant, de los Laboratorios Nacionales

Sandia, cuenta con 580 procesadores Alpha de Compaq y ocupa el octogesimocuarto

lugar en el ranking. La Fundación Nacional para la Ciencia y el

Departamento de Energía proyectan construir agrupaciones avanzadas

que operen en el rango de los teraflop (un billón de operaciones

de coma flotante al segundo), compitiendo con la velocidad de los superordenadores

más rápidos del planeta.

Los sistemas Beowulf también se están abriendo camino

en el ámbito empresarial. Las compañías de productos

informáticos comienzan a vender agrupaciones a empresas con un alto

nivel de informatización. IBM, por ejemplo, está construyendo

una agrupación de 1250 servidores para NuTec Sciences, empresa de

biotecnología que proyecta dedicar el sistema a la identificación

de genes responsables de enfermedades. De parejo interés es la tendencia

hacia el desarrollo de redes de PC que contribuyen con su potencia de procesamiento

a tareas colectivas. Pensamos en SETI@home, lanzado por investigadores

de la Universidad de California en Berkeley que analizan señales

de radio del espacio profundo en su búsqueda de señales de

vida inteligente. SETI@home envía chorros de datos vía Internet

a más de tres millones de PC, que procesan los datos de radioseñales

en su tiempo libre. Algunos expertos de la industria de los ordenadores

predicen que los investigadores terminarán por crear un tendido

computacional similar a la red energética: los usuarios podrán

obtener capacidad de procesado con la misma facilidad con que ahora contratan

suministro eléctrico.

El sistema Beowulf es, por encima de todo, una fuerza multiplicadora.

Acerca la computación de alto nivel, exclusiva de unos pocos privilegiados,

a los sistemas de bajo coste de procesado en paralelo, accesibles para

la mayoría con recursos modestos. Grupos de investigación,

universidades o pequeñas empresas pueden construir sus propias agrupaciones

Beowulf, su propio superordenador.

Bibliografía complementaria:

Cluster computing: Linux taken to the extreme. F. M. Hoffman

y W. W. Hargrove en Linux Magazine, volumen 1, número 1,

páginas 56- 59; primavera 1999.

Using multivariate clustering to characterize ecoregion borders.

W. W. Hargrove y F. M. Hoffman en Computers in Science and Engineering,

volumen 1, número 4, páginas 18-25; julio/agosto 1999.

How to build a beowulf: a guide to the implementation and application

of PC clusters. Dirigido por T. Sterling, J. Salmon, D. J. Becker y

D. F. Savarese. MIT Press, 1999.

1. Agrupación de ordenadores personales en el Laboratorio Nacional de Oak Ridge en Tennessee. Por su carácter artesanal se le ha dado el nombre de «superordenador de piedra».

2. Sistema formado por monitor y teclado para resolver los problemas que puedan surgir en el funcionamiento correcto del superordenador de piedra.

3. Agrupación de ordenadores del Museo Americano de Historia Natural de Nueva York. Contiene 560 microprocesadores Pentium III. Los investigadores hacen uso del sistema para el estudio de la formación de estrellas y su evolución.

Una agrupación de ordenadores.

Agrupación de ordenadores.

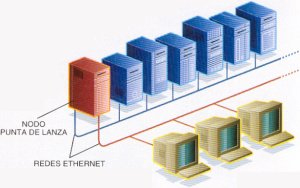

Agrupación de ordenadores. El «superordenador de piedra» del Laboratorio Nacional de Oak Rigde consta de más de 130 PC enlazados entre sí para formar una agrupación. Una de las máquinas desempeña la labor de punta de lanza para la agrupación; cuenta con dos tarjetas Ethernet, una para comunicarse con los usuarios y redes externas y otra para la comunicación con el resto de nodos de la agrupación. El sistema resuelve los problemas mediante el procesado en paralelo divide la carga operacional en multitud de tareas, asignadas a los nodos. Los PC coordinan sus tareas y comparten resultados intermedios a través del intercambio de mensajes.

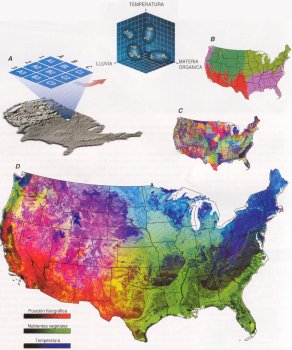

Cartografía con el ordenador de

piedra.

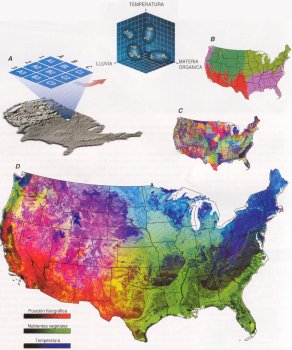

Para levantar el mapa de las ecorregiones de los estados contiguos de

la Unión, nuestro superordenador de piedra comparó 25 variables

ambientales de 7,8 millones celdas de un kilómetro cuadrado. A modo

de ejemplo, considérese la clasificación de nueve celdas

basada en sólo tres variables (temperatura, precipitación

y materia orgánica contenida en el suelo).

La figura A muestra la forma en que la agrupación de ordenadores

personales representaría las celdas en un espacio de datos tridimensional

y las agruparía en cuatro ecorregiones. El mapa de cuatro regiones

divide la nación en zonas reconocibles (figura B); el mapa

que divide el país en 1.000 ecorregiones proporciona más

detalle (C). Otra aproximación es la representación

de las tres características con una gradación de rojo, verde

y azul (D).

Cartografía con el superordenador de piedra.

William

W. Hargrove, Forrest M. Hoffman y Thomas Sterling han

participado en el desarrollo del sistema Beowulf. Hargrove trabaja en el

departamento de física e ingeniería de la computación

del Laboratorio Nacional Oak Ridge (ORNL) en Tennessee, en cuyo departamento

de ciencias ambientales Hoffman, especialista en ordenadores, presta sus

servicios. Sterling creó la primera agrupación Beowulf mientras

investigaba en el Centro Goddard de Vuelos Espaciales de la NASA. Hoy se

halla adscrito al Instituto de Tecnología de California.

Enlaces relacionados:

El Milagro de Wörgl (2018).

Nace KmCat, la red cooperativa de kilómetro cero. Xarxanet. Colectic. Xavi Aranda.

La moneda y la constitución.

El momento es ahora. Manifiesto de los expertos monetarios integrados en el Instituto de la Moneda Social y el Observatorio de la Moneda Complementaria.

Martí Olivella: «Con el REC, como ciudadanía podemos construir un grado de soberanía en el campo monetario».

La moneda es fuente de vida. Martí Olivella.

Presentación de la moneda local de Barcelona, el Rec.

En defensa de las secciones de crédito de las cooperativas agrarias catalanas.

Barcelona tendrá el próximo año una moneda local virtual.

Jordi Griera: «La inteligencia artificial debe ser de código abierto y de titularidad pública».

La desunión fiscal europea. Joan Casals.

La moneda social por Jordi Griera.

Concursante (fragmento).

El Banco Central de Canadá podría recuperar su capacidad de emitir y entregar dinero al estado sin la banca privada como intermediaria: un revolucionario caso judicial silenciado en los medios.

Dos entrevistas a Martin Armstrong. El visionario.

Najia Lotfi: «El Corán promueve la economía social». La banca sin interés.

Crear un centro de cálculo y procesamiento de datos con agrupaciones de ordenadores de segunda mano, además de los proyectos expuestos en el artículo siguiente, puede permitir, con los modelos disponibles en la actualidad, iniciativas que podrían gestionar, por ejemplo, unas cada vez más extensas redes monetarias nominativas locales o regionales, ya sean a nivel de municipios, comarcas o incluso de comunidades geopolíticas soberanas.

Crear un centro de cálculo y procesamiento de datos con agrupaciones de ordenadores de segunda mano, además de los proyectos expuestos en el artículo siguiente, puede permitir, con los modelos disponibles en la actualidad, iniciativas que podrían gestionar, por ejemplo, unas cada vez más extensas redes monetarias nominativas locales o regionales, ya sean a nivel de municipios, comarcas o incluso de comunidades geopolíticas soberanas.